KI-Chatbots kommen in immer mehr Unternehmen zum Einsatz. Doch Chatbot ist nicht gleich Chatbot. Manche Lösungen lassen sich zwar schnell und relativ leicht implementieren. Doch mangelt es ihnen an Konfigurierbarkeit (Customizability) und den Funktionalitäten, die wirklich große Leistungssprünge, z. B. bei der Beantwortung von Kundenanfragen im Customer Service, ermöglichen. Customized Lösungen, die genau das bieten, können wiederum aufwändig und teuer werden – besonders, wenn sie über komplexe und use-case-spezifische Retrieval-Augmented Generation (RAG) verfügen sollen. Die Technik verbessert die Genauigkeit und Zuverlässigkeit von generativen KI-Modellen, indem sie es ermöglicht, z. B. mit unternehmenseigenen Datenbanken zu chatten und nur gesicherte Fakten auszugeben.

Wie funktionieren Chatbots?

Custom GPT-Chatbots lernen aus großen Mengen von Texten, um Zusammenhänge zu verstehen und Muster zu erkennen. Sie werden so programmiert, dass sie individuell auf verschiedene Nutzer:innenanfragen eingehen können. Die Erstellung solcher Chatbots umfasst die maßgeschneiderte Anpassung an bestimmte Bedürfnisse, das gezielte Trainieren mit ausgewählten Daten und das Einbinden in Plattformen wie Websites oder mobile Anwendungen.

CustomGPT von statworx zeichnet sich dadurch aus, dass es das Beste aus beiden Welten – hohe Funktionalität durch Customizability und schnelle Implementierung – miteinander verbindet. Die Lösung ist maßgeschneidert und ermöglicht eine sichere und effiziente Nutzung von ChatGPT-ähnlichen Modellen. Das Interface lässt sich im Corporate Design eines Unternehmens gestalten und leicht in bestehende Geschäftsanwendungen wie CRM-Systeme und Support-Tools integrieren.

Worauf kommt es also an, wenn Unternehmen die ideale Chatbot-Lösung für ihre Bedürfnisse suchen?

Anforderungsanalyse: Zunächst sollten die spezifischen Anforderungen des Unternehmens identifiziert werden, um sicherzustellen, dass der Chatbot optimal auf diese zugeschnitten ist. Welche Aufgaben soll der Chatbot bearbeiten? Welche Abteilungen soll er unterstützen? Welche Funktionen braucht er?

Training des Modells: Ein custom GPT-Chatbots muss mit relevanten Daten und Informationen ausgestattet werden, um eine hohe Genauigkeit und Reaktionsfähigkeit sicherzustellen. Wenn diese Daten nicht verfügbar sind, lohnt sich der technische Aufwand wahrscheinlich nicht.

Integration in bestehende Systeme: Die nahtlose Integration des Chatbots in bestehende Kommunikationskanäle wie Websites, Apps oder soziale Medien ist entscheidend für eine effektive Nutzung. Je nach Infrastruktur eignen sich unterschiedliche Lösungen.

Schnell einsatzbereit und immer anpassungsfähig

Der CustomGPT-Chatbot von statworx zeichnet sich durch seine schnelle Einsatzfähigkeit aus, oft schon innerhalb weniger Wochen. Diese Effizienz verdankt er einer Kombination aus bewährten Standardlösungen und maßgeschneiderter Anpassung an die speziellen Bedürfnisse eines Unternehmens. CustomGPT ermöglicht den Upload von Dateien und die Möglichkeit, mit ihnen zu chatten, also gesicherte Informationen aus den unternehmenseigenen Daten zu ziehen. Mit fortschrittlichen Funktionen wie Faktenprüfung, Datenfilterung und der Möglichkeit, Nutzer:innenfeedback zu integrieren, hebt sich der Chatbot von anderen Systemen ab.

Darüber hinaus bietet CustomGPT Unternehmen die Freiheit, das Vokabular, den Kommunikationsstil und den generellen Ton ihres Chatbots zu bestimmen. Dies ermöglicht nicht nur ein nahtloses Markenerlebnis für die Nutzer:innen, sondern verstärkt auch die Wiedererkennung der Unternehmensidentität durch eine persönliche und einzigartige Interaktion. Ein besonderes Highlight: der Chatbot ist optimiert für die mobile Darstellung auf Smartphones.

Technische Umsetzung

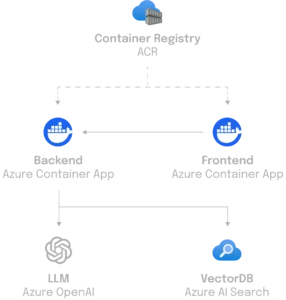

Im Bestreben, eine hochmoderne Anwendung zu schaffen, die sich leicht warten lässt, wurde Python als Kernsprache für das Backend von CustomGPT verwendet. Für die effiziente Handhabung von Anfragen setzen die statworx-Entwickler:innen auf FastAPI, eine moderne Webframework-Lösung, die sowohl Websockets für eine zustandsorientierte Kommunikation als auch eine REST-API für die Dienste bereitstellt. CustomGPT kann flexibel auf unterschiedlichen Infrastrukturen eingesetzt werden – von einer einfachen Cloud-Function bis zu einem Maschinencluster, wenn die Anforderungen dies erfordern.

Ein wesentlicher Aspekt der Architektur ist die Anbindung an eine Datenschicht, um ein flexibles Backend zu bieten, das sich schnell an veränderte Bedingungen und Anforderungen anpassen kann. Die Frontend-Applikation, entwickelt mit React, interagiert nahtlos über Websockets mit dem Backend, welches zum Beispiel die leistungsfähige Azure-AI-Suchfunktion nutzt. Die Konfiguration des Backends ermöglicht es, zusätzliche Use-Cases, wie zum Beispiel maßgeschneiderte Suchlösungen zu implementieren und spezifische Anforderungen effizient zu erfüllen.

Die Vorteile im Überblick:

Datenschutz und Sicherheit

Datenschutz und Datensicherheit sind zentrale Aspekte von CustomGPT. Es gewährleistet, dass alle Daten in der Europäischen Union gespeichert und verarbeitet werden und die vollständige Kontrolle beim Unternehmen liegt. Das ist ein entscheidender Unterschied zu anderen GPT-basierten Lösungen.

Integration und Flexibilität

Die flexible Integration von CustomGPT in bestehende Geschäftsanwendungen ist ein weiterer Vorteil. Dies wird durch Modularität und Anbieterunabhängigkeit unterstützt. Damit kann CustomGPT an verschiedene Infrastrukturen und Modelle angepasst werden, einschließlich Open-Source-Optionen.

Funktionen und Anpassungsmöglichkeiten

Die Anpassungsmöglichkeiten von CustomGPT umfassen die Integration in Organisationsdaten, die Anpassung an Benutzerrollen und die Verwendung von Analytics zur Verbesserung der Konversationen. Durch die Verwendung von Standardmodellen sowie die Möglichkeit, auf Open-Source-Modelle zu setzen, bietet CustomGPT Flexibilität und Individualisierung für Unternehmensanwendungen.

Personalisierte Kundenerfahrung

Durch die Anpassung an die spezifischen Anforderungen eines Unternehmens können Custom GPT-Chatbots eine personalisierte und effektive Interaktion mit Kund:innen gewährleisten.

Effiziente Kundenbetreuung

CustomGPT Chatbots können rund um die Uhr Fragen beantworten, Probleme lösen und Informationen bereitstellen, was zu einer erhöhten Kund:innenzufriedenheit und Effizienz führt.

Skalierbarkeit

Unternehmen können die Kapazität, z. B. ihrer Kund:innenbetreuung mithilfe von GPT-Chatbots problemlos skalieren, um auch bei hohem Aufkommen eine konsistente Servicequalität zu gewährleisten.

Die Zeit für einen eigenen Chatbot ist jetzt! Profitieren Sie von unserer Upstream-Entwicklung mit schneller Bereitstellung und einfacher Implementierung. Als CustomGPT-Kunde stehen Ihnen alle Patches, Bugfixes und neue Funktionalitäten, die im Laufe der Zeit hinzukommen, direkt zur Verfügung. So bleibt Ihr CustomGPT stets so vielseitig und flexibel, dass es den spezifischen, sich ändernden Bedürfnissen gerecht wird und komplexe Anforderungen adressieren kann. Kontaktieren Sie uns jetzt für ein Beratungsgespräch.

Wir stehen am Beginn des Jahres 2024, einer Zeit grundlegender Veränderungen und spannender Fortschritte in der Welt der Künstlichen Intelligenz. Die nächsten Monate gelten als kritischer Meilenstein in der Evolution der KI, in denen sie sich von einer vielversprechenden Zukunftstechnologie zu einer festen Realität im Geschäftsleben und im Alltag von Millionen wandelt. Deshalb präsentieren wir gemeinsamen mit dem AI Hub Frankfurt, dem zentralen KI-Netzwerk der Rhein-Main-Region, unsere Trendprognose für 2024, den AI Trends Report 2024.

Der Report identifiziert zwölf dynamische KI-Trends, die sich in drei Schlüsselbereichen entfalten: Kultur und Entwicklung, Daten und Technologie sowie Transparenz und Kontrolle. Diese Trends zeichnen ein Bild der rasanten Veränderungen in der KI-Landschaft und beleuchten die Auswirkungen auf Unternehmen und Gesellschaft.

Unsere Analyse basiert auf umfangreichen Recherchen, branchenspezifischem Fachwissen und dem Input von Expert:innen. Wir beleuchten jeden Trend, um einen zukunftsweisenden Einblick in die KI zu bieten und Unternehmen bei der Vorbereitung auf künftige Herausforderungen und Chancen zu unterstützen. Wir betonen jedoch, dass Trendprognosen stets einen spekulativen Charakter haben und einige unserer Vorhersagen bewusst gewagt formuliert sind.

Direkt zum AI Trends Report 2024!

Was ist ein Trend?

Ein Trend unterscheidet sich sowohl von einem kurzlebigen Modephänomen als auch von einem medialen Hype. Er ist ein Wandelphänomen mit einem „Tipping Point“, an dem eine kleine Veränderung in einer Nische einen großen Umbruch im Mainstream bewirken kann. Trends initiieren neue Geschäftsmodelle, Konsumverhalten und Arbeitsformen und stellen somit eine grundlegende Veränderung des Status Quo dar. Für Unternehmen ist es entscheidend, vor dem Tipping Point die richtigen Kenntnisse und Ressourcen zu mobilisieren, um von einem Trend profitieren zu können.

12 KI-Trends, die 2024 prägen werden

Im AI Trends Report 2024 identifizieren wir wegweisende Entwicklungen im Bereich Künstlichen Intelligenz. Hier sind die Kurzversionen der zwölf Trends mit jeweils einem ausgewählten Zitat aus den Reihen unserer Expert:innen.

Teil 1: Kultur und Entwicklung

Von der 4-Tage-Woche über Omnimodalität bis AGI: 2024 verspricht große Fortschritt für die Arbeitswelt, für die Medienproduktion und für die Möglichkeiten von KI insgesamt.

These I: KI-Kompetenz im Unternehmen

Unternehmen, die KI-Expertise tief in ihrer Unternehmenskultur verankern und interdisziplinäre Teams mit Tech- und Branchenwissen aufbauen, sichern sich einen Wettbewerbsvorteil. Zentrale KI-Teams und eine starke Data Culture sind Schlüssel zum Erfolg.

„Eine Datenkultur kann man weder kaufen noch anordnen. Man muss die Köpfe, die Herzen und die Herde gewinnen. Wir möchten, dass unsere Mitarbeitenden bewusst Daten erstellen, nutzen und weitergeben. Wir geben ihnen Zugang zu Daten, Analysen und KI und vermitteln das Wissen und die Denkweise, um das Unternehmen auf Basis von Daten zu führen.“

Stefanie Babka, Global Head of Data Culture, Merck

These II :4-Tage-Arbeitswoche durch KI

Dank KI-Automatisierung in Standardsoftware und Unternehmensprozessen ist die 4-Tage-Arbeitswoche für einige deutsche Unternehmen Realität geworden. KI-Tools wie Microsofts Copilot steigern die Produktivität und ermöglichen Arbeitszeitverkürzungen, ohne das Wachstum zu beeinträchtigen.

Dr. Jean Enno Charton, Director Digital Ethics & Bioethics, Merck

These III: AGI durch omnimodale Modelle

Die Entwicklung von omnimodalen KI-Modellen, die menschliche Sinne nachahmen, rückt die Vision einer allgemeinen künstlichen Intelligenz (AGI) näher. Diese Modelle verarbeiten vielfältige Inputs und erweitern menschliche Fähigkeiten.

Dr. Ingo Marquart, NLP Subject Matter Lead, statworx

These IV: KI-Revolution in der Medienproduktion

Generative AI (GenAI) transformiert die Medienlandschaft und ermöglicht neue Formen der Kreativität, bleibt jedoch noch hinter transformatorischer Kreativität zurück. KI-Tools werden für Kreative immer wichtiger, doch es gilt, die Einzigartigkeit gegenüber einem globalen Durchschnittsgeschmack zu wahren.

Nemo Tronnier, Founder & CEO, Social DNA

Teil 2: Daten und Technologie

2024 dreht sich alles um Datenqualität, Open-Source-Modelle und den Zugang zu Prozessoren. Die Betreiber von Standardsoftware wie Microsoft und SAP werden groß profitieren, weil sie die Schnittstelle zu den Endnutzer:innen besetzen.

These V: Herausforderer für NVIDIA

Neue Akteure und Technologien bereiten sich vor, den GPU-Markt aufzumischen und NVIDIAs Position herauszufordern. Startups und etablierte Konkurrenten wie AMD und Intel wollen von der Ressourcenknappheit und den langen Wartezeiten profitieren, die kleinere Player derzeit erleben, und setzen auf Innovation, um NVIDIAs Dominanz zu brechen.

Norman Behrend, Chief Customer Officer, Genesis Cloud

These VI: Datenqualität vor Datenquantität

In der KI-Entwicklung rückt die Qualität der Daten in den Fokus. Statt nur auf Masse zu setzen, wird die sorgfältige Auswahl und Aufbereitung von Trainingsdaten sowie die Innovation in der Modellarchitektur entscheidend. Kleinere Modelle mit hochwertigen Daten können größeren Modellen in der Performance überlegen sein.

Walid Mehanna, Chief Data & AI Officer, Merck

These VII: Das Jahr der KI-Integratoren

Integratoren wie Microsoft, Databricks und Salesforce werden zu den Gewinnern, da sie KI-Tools an Endnutzer:innen bringen. Die Fähigkeit zur nahtlosen Integration in bestehende Systeme wird für KI-Startups und -Anbieter entscheidend sein. Unternehmen, die spezialisierte Dienste oder wegweisende Innovationen bieten, sichern sich lukrative Nischen.

Marco Di Sazio, Head of Innovation, Bankhaus Metzler

These VIII: Die Open-Source-Revolution

Open-Source-KI-Modelle treten in Wettbewerb mit proprietären Modellen wie OpenAIs GPT und Googles Gemini. Mit einer Community, die Innovation und Wissensaustausch fördert, bieten Open-Source-Modelle mehr Flexibilität und Transparenz, was sie besonders wertvoll für Anwendungen macht, die klare Verantwortlichkeiten und Anpassungen erfordern.

Prof. Dr. Christian Klein, Gründer, UMYNO Solutions, Professor für Marketing & Digital Media, FOM Hochschule

Teil 3: Transparenz und Kontrolle

Die verstärkte Nutzung von KI-Entscheidungssystemen wird 2024 eine intensivierte Debatte über Algorithmen-Transparenz und Datenschutz entfachen – auf der Suche nach Verantwortlichkeit. Der AI Act wird dabei zum Standortvorteil für Europa.

These IX: KI-Transparenz als Wettbewerbsvorteil

Europäische KI-Startups mit Fokus auf Transparenz und Erklärbarkeit könnten zu den großen Gewinnern werden, da Branchen wie Pharma und Finance bereits hohe Anforderungen an die Nachvollziehbarkeit von KI-Entscheidungen stellen. Der AI Act fördert diese Entwicklung, indem er Transparenz und Anpassungsfähigkeit von KI-Systemen fordert und damit europäischen KI-Lösungen zu einem Vertrauensvorsprung verhilft.

Jakob Plesner, Rechtsanwalt, Gorrissen Federspiel

These X: AI Act als Qualitätssiegel

Der AI Act positioniert Europa als sicheren Hafen für Investitionen in KI, indem er ethische Standards setzt, die das Vertrauen in KI-Technologien stärken. Angesichts der Zunahme von Deepfakes und der damit verbundenen Risiken für die Gesellschaft wirkt der AI Act als Bollwerk gegen Missbrauch und fördert ein verantwortungsbewusstes Wachstum der KI-Branche.

Catharina Glugla, Head of Data, Cyber & Tech Germany, Allen & Overy LLP

These XI: KI-Agenten revolutionieren den Konsum

Persönliche Assistenz-Bots, die Einkäufe tätigen und Dienstleistungen auswählen, werden zu einem wesentlichen Bestandteil des Alltags. Die Beeinflussung ihrer Entscheidungen wird zum Schlüsselelement für Unternehmen, um auf dem Markt zu bestehen. Dies wird die Suchmaschinenoptimierung und Online-Marketing tiefgreifend verändern, da Bots zu den neuen Zielgruppen werden.

Chi Wang, Principle Researcher, Microsoft Research

These XII: Alignment von KI-Modellen

Die Abstimmung (Alignment) von KI-Modellen auf universelle Werte und menschliche Intentionen wird entscheidend, um unethische Ergebnisse zu vermeiden und das Potenzial von Foundation-Modellen voll auszuschöpfen. Superalignment, bei dem KI-Modelle zusammenarbeiten, um komplexe Herausforderungen zu meistern, wird immer wichtiger, um die Entwicklung von KI verantwortungsvoll voranzutreiben.

Daniel Lüttgau, Head of AI Development, statworx

Schlussbemerkung

Der AI Trends Report 2024 ist mehr als eine unterhaltsame Bestandsaufnahme; er kann ein nützliches Werkzeug für Entscheidungsträger:innen und Innovator:innen sein. Unser Ziel ist es, unseren Leser:innen strategische Vorteile zu verschaffen, indem wir die Auswirkungen der Trends auf verschiedene Sektoren diskutieren und ihnen helfen, die Weichen für die Zukunft zu stellen.

Dieser Blogpost bietet nur einen kurzen Einblick in den umfassenden AI Trends Report 2024. Wir laden Sie ein, den vollständigen Report zu lesen, um tiefer in die Materie einzutauchen und von den detaillierten Analysen und Prognosen zu profitieren.

Geschäftserfolg steht und fällt mit der Art und Weise, wie Unternehmen mit ihren Kund:innen interagieren. Kein Unternehmen kann es sich leisten, mangelhafte Betreuung und Support anzubieten. Im Gegenteil: Firmen, die eine schnelle und präzise Bearbeitung von Kundenanfragen anbieten, können sich vom Wettbewerb absetzen, Vertrauen in die eigene Marke aufbauen und so Menschen langfristig an sich binden. Wie das mithilfe von generativer KI auf einem ganz neuen Niveau gelingt, zeigt unsere Zusammenarbeit mit Geberit, einem führenden Hersteller von Sanitärtechnik in Europa.

Was ist generative KI?

Generative KI-Modelle erstellen automatisiert Inhalte aus vorhandenen Text-, Bild- und Audiodateien. Dank intelligenter Algorithmen und Deep Learning unterscheiden sich diese Inhalte kaum oder gar nicht von menschengemachten. Unternehmen können ihren Kund:innen so personalisierte User Experiences bieten, automatisiert mit ihnen interagieren und relevanten digitalen Content zielgruppengerecht erstellen und ausspielen. GenAI kann zudem komplexe Aufgaben lösen, indem die Technologie riesige Datenmengen verarbeitet, Muster erkennt und neue Fähigkeiten lernt. So ermöglicht die Technologie ungeahnte Produktivitätsgewinne. Routineaufgaben wie Datenaufbereitung, Berichterstellung und Datenbanksuchen lassen sich automatisieren und mit passenden Modellen um ein Vielfaches optimieren.

Weitere Informationen zum Thema GenAI finden Sie hier.

Die Herausforderung: Eine Million E-Mails

Geberit sah sich mit einem Problem konfrontiert: Jedes Jahr landeten eine Million E-Mails in den unterschiedlichen Postfächern des Kundenservice der deutschen Vertriebsgesellschaft von Geberit. Dabei kam es oft vor, dass Anfragen in den falschen Abteilungen landeten, was zu einem erheblichen Mehraufwand führte.

Die Lösung: Ein KI-gestützter E-Mail-Bot

Um die falsche Adressierung zu korrigieren, haben wir ein KI-System entwickelt, das E-Mails automatisch den richtigen Abteilungen zuordnet. Dieses intelligente Klassifikationssystem wurde mit einem Datensatz von anonymisierten Kundenanfragen trainiert und nutzt fortschrittliche Machine- und Deep-Learning-Methoden, darunter das BERT-Modell von Google.

Der Clou: Automatisierte Antwortvorschläge mit ChatGPT

Doch die Innovation hörte hier nicht auf. Das System wurde weiterentwickelt, um automatisierte Antwort-E-Mails zu generieren. Hierbei kommt ChatGPT zum Einsatz, um kundenspezifische Vorschläge zu erstellen. Die Kundenberater:innen müssen die generierten E-Mails nur noch prüfen und können sie direkt versenden.

Das Ergebnis: 70 Prozent bessere Sortierung

Das Ergebnis dieser bahnbrechenden Lösung spricht für sich: eine Reduzierung der falsch zugeordneten E-Mails um über 70 Prozent. Das bedeutet nicht nur eine erhebliche Zeitersparnis von fast drei ganzen Arbeitsmonaten, sondern auch eine Optimierung der Ressourcen.

Der Erfolg des Projekts schlägt hohe Wellen bei Geberit: Ein Sammelpostfach für alle Anfragen, die Ausweitung in andere Ländermärkte und sogar ein digitaler Assistent sind in Planung.

Kundenservice 2.0 – Innovation, Effizienz, Zufriedenheit

Die Einführung von GenAI hat nicht nur den Kundenservice von Geberit revolutioniert, sondern zeigt auch, welches Potenzial in der gezielten Anwendung von KI-Technologien liegt. Die intelligente Klassifizierung von Anfragen und die automatisierte Antwortgenerierung spart nicht nur Ressourcen, sondern steigert auch die Zufriedenheit der Kund:innen. Ein wegweisendes Beispiel dafür, wie KI die Zukunft des Kundenservice gestaltet. Egal in welcher Branche!

Read next …

… and explore new

Ticket sichern! Zur Case Study

Das globale Wirtschaftsumfeld wird immer schnelllebiger und volatiler. Aber eines ändert sich nie: Kompetenter, effektiver Customer Support ist und bleibt einer der wichtigsten Schlüssel zu dauerhaftem Geschäftserfolg. Denn guter Service bindet Kund:innen und sorgt dafür, dass sie immer wieder zurückkehren. Doch wie bewältigen Unternehmen die Flut von anspruchsvollen Kundenanfragen, um genau das zu gewährleisten? Hier bietet generative Künstliche Intelligenz (GenAI) bislang unerreichte Möglichkeiten.

Gemeinsam mit Geberit haben wir ein KI-System entwickelt, das Kundenanfragen intelligent sortiert und automatisch Antworten erstellt. Im gemeinsamen Webinar sprechen wir über die innovative Lösung.

Freue dich auf folgende Inhalte:

- Die Meilensteine des Projekts: Wir führen euch von der Herausforderung über die erste Idee bis hin zu unerwarteten Entwicklungen des Projekts.

- Die Funktionsweise unseres KI-Tools: Wir erklären in einfachen Worten, wie die maßgeschneiderte KI-Lösung funktioniert.

- Die Ergebnisse und der Business Impact: Wir zeigen, wie Geberit von der Customer Support Automation profitiert und wie andere Unternehmen das ebenfalls können!

Dich erwarten folgende Speaker:

- Dr. Tilo Sperling, Head of AI-Projects Business Applications, Geberit

- Dominique Lade, Senior Consultant, statworx

Jetzt kostenlos registrieren!

Allen registrierten Teilnehmer:innen wird im Anschluss eine Aufzeichnung des Webinars zugesandt.

Ticket sichern! Zur Case Study